본 포스팅은 패스트캠퍼스 환급 챌린지 참여를 위해 작성하였습니다.

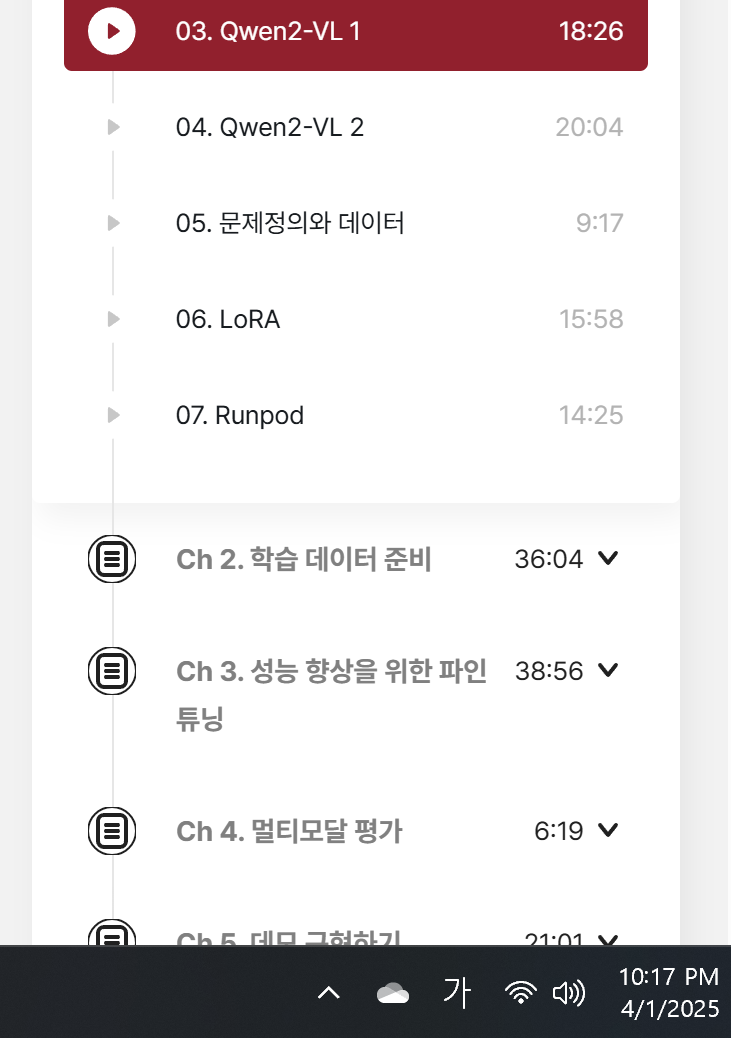

1. 학습 인증샷 4장

2. 학습 후기 700자 이상 (공백 제외)

기존에 공부하던 내용에서 좀더 연장해서 공부중이다. QWEN모델에 대해 알고 있는 것 보다 좀 더 깊이있는 이해가 가능했다.

단순히 알리바바에서 만든 LLM 정도로만 알고 있었던 Qwen 시리즈가, 사실은 텍스트 전용 모델뿐 아니라 이미지와 텍스트를 함께 이해하는 멀티모달 모델도 존재한다는 점에서 인상 깊었다. 특히 Qwen2-VL 모델이 버전에 따라 어떤 구조와 파라미터를 갖고 있는지, 왜 비전 인코더는 동일하고 LLM 파라미터만 달라지는지 구조적으로 파악할 수 있었고, 각 모델이 어떤 환경과 용도에 적합한지도 명확하게 구분되었다.

예를 들어 2B 모델은 온디바이스처럼 리소스가 부족한 환경에서도 동작할 수 있고, 7B 모델은 텍스트 인식과 영상 이해에 최적화되어 있으며, 72B는 복잡한 에이전트 기능까지 수행할 수 있다는 점이 매우 흥미로웠다.

또한 멀티모달 구조의 기본적인 흐름인 "이미지 인코딩 → 텍스트 처리" 과정이 실제로 어떻게 연결되는지, 어떤 방식으로 Vision Transformer와 LLM이 통합되는지를 확인하면서, 향후 나의 프로젝트에서 어떤 구조로 활용할 수 있을지도 감이 잡히기 시작했다.

특히 OCR, 이미지 캡셔닝, 질의응답 같은 기능이 실제로 어떻게 작동하고 어떤 산업에 적용될 수 있는지도 사례를 통해 확인하면서 실무 적용 가능성까지 생각해보게 되었다.

단순히 모델의 크기와 성능을 보는 것이 아니라, 모델 구조와 목적에 따라 어떤 상황에서 어떤 모델을 선택하는 것이 적절한지를 스스로 판단할 수 있게 되었다는 점이 이번 학습의 가장 큰 수확이었다.

Qwen 시리즈가 오픈소스로 제공된다는 점도 굉장히 큰 장점인데, 이를 활용해 직접 커스터마이징하거나 파인튜닝해볼 수 있다는 가능성까지 고려하게 되었다. 앞으로 멀티모달 시스템을 설계하거나 관련 AI 서비스를 구현할 때 Qwen 모델을 유력한 옵션으로 생각할 수 있을 만큼 깊은 이해를 얻게 된 계기였다.

필수 URL 가이드

https://abit.ly/lisbva

Abit.ly 다운받기

abit.ly

#패스트캠퍼스 #환급챌린지 #패스트캠퍼스후기 #습관형성 #직장인자기계발 #오공완